AIコネクティビティ時代の到来

Kongは「接続(Connectivity)」のために生まれました。世界は今、クラウドサービスとアプリを繋ぐ段階から、エージェントを通じてLLM(大規模言語モデル)を繋ぐ段階へと移行しています。APIコールとトークンは連動して動き、新たな「インテリジェンスの単位」が形成されつつあります。AIトラフィックが「超大規模」へと爆発的に増加する中で、重要になるのはスピードです。Kongを支えるパフォーマンス、セキュリティ、信頼性の原則は、エージェント主導の世界(Agentic World)においても不可欠です。AIのための新たなコネクティビティレイヤーが誕生しました。

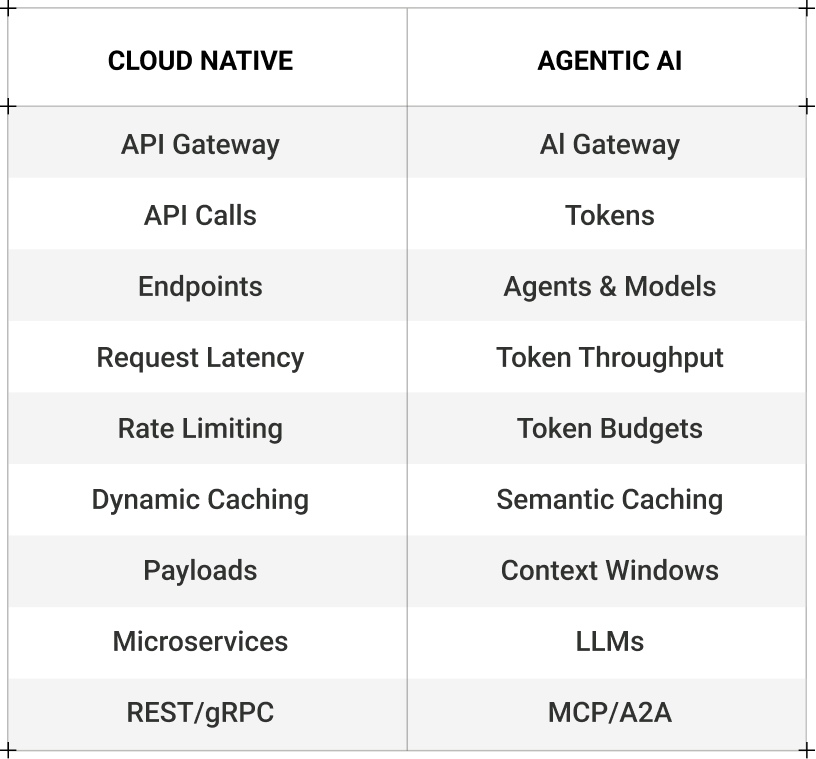

クラウドネイティブから「エージェンティックAI」へ

10年前、私たちはソフトウェアの基本構成要素であるAPIを通じて世界を繋ぐことを決意しました。Kongを立ち上げる前、私たちは開発者がアプリを構築するためのアセンブリラインを提供する初のAPIマーケットプレイス「Mashape」を設立しました。その後、そのコアとなるAPIランタイムであり、世界最速のクラウドネイティブAPIゲートウェイである「Kong」をオープンソース化しました。

Kong Inc.は2017年の夏に正式に誕生しました。マイクロサービスとクラウドアプリケーションの新時代が解き放たれたのです。その瞬間から、私たちは小さなオープンソースゲートウェイから、GitHubでNo.1のAPIリポジトリ、それから世界中の何千もの組織で使用される主要なクラウドAPI管理プラットフォームへと成長しました。ガートナーやフォーブスなどからも、リーダーであり、クラウドインフラにおける最もビジョナリーな企業の一つとして認められています。

今日、世界は新たな転換点である「エージェンティックAI(Agentic AI)」に直面しています。コネクティビティ(接続性)という本質は変わりません。開発者は依然として、サービスと人間を繋ぐクラウドネイティブなアプリを構築する必要があります。しかし、AIの真の「製品化」とも言える「エージェント」という、新たな消費主体が登場しています。

初めて、インターネットは単なるグラフィカルUI(GUI)ではなく、プログラミングインターフェース(間もなく音声も加わります)が主役となりました。APIは、人間ではなくマシン間の消費のために構築された「エージェント世界のUI」です。エージェントは、私たちが現時点で想像もできないほどの規模で、それらのインターフェースを使いこなしていくでしょう。彼らは人間よりも速く発見し、学習し、取引を行います。新しいスタックが登場し、バックエンドは変化します。例えば、クラウドネイティブアプリでは主にSQLデータベースを使用しますが、エージェントの世界では、ストレージと計算が分離されたデータベース、ベクトルデータベース、レイクハウス、そして「データ重力」の源泉としてのLLMを使用することになります。

マウスのクリック、ポイント、スクロールの重要性は低下します。これらは物事が行き詰まった時にのみ使われるようになるでしょう。人間の入力を音声でオーバーレイした「エージェンティック・ワークフロー」が、インターネット消費の主要な方法となります。たとえエージェントの革新が停滞したとしても、より専門化されたエージェントが導入されることでオーケストレーションの複雑さが増し、トラフィックと接続の課題が大きくなるにつれて、Kongの必要性はさらに高まります。

次なる大きな探求は、クラウドサービスの接続から「インテリジェンス」の接続への移行です。AIコネクティビティ時代の到来です。

APIコール + トークン

クラウド時代の「接続」は、純粋なREST形式のAPIコールでした。しかしAIの時代において、私たちはまた別の転換点、すなわち「トークン」に立っています。トークンは、APIトラフィックとAIトラフィックが交差する場所に位置しています。

APIは呼び出す(Call)だけでなく、今や「考える」存在となりました。APIトラフィックにインテリジェンスの層が加わっています。リクエストがエンドポイントを離れる前、あるいはMCP(Model Context Protocol)接続が確立される前に、そこにはコンテキスト、メモリ、推論が存在します。遠くない将来、トラフィックそのものがインテリジェントになるでしょう。

次世代のインターネットは、単にアプリケーションを動かすAPIコールだけで構成されるのではありません。トークンを介してインテリジェンスを往復させるモデル、AIエージェント、音声アシスタント、そしてコパイロットによって構成されます。システムがモデルにプロンプトを送信するたびに、コンテキストウィンドウごとに、そしてエージェント間の会話ごとに、新しいタイプの「トークントラフィック」が生成されます。しかし、なぜこれが重要なのでしょうか?

山脈の要所(マウンテン・パス)

私は、AIガバナンスの勝敗はまさにここで決まると信じています。AIが流通し取引されるためには、安全に統治されなければなりません。初期の市場ポジショニングでは、自然な重力によってこのタスクはデータプラットフォームに近い場所に置かれていますが、単一のデータプラットフォームを持つ企業は存在しません。したがって、異なるクラウド、データ、モデルが混在する「ヘテロジニアス(異種混合)」な環境を管理するのに最適な場所は、中立的なトラフィックレイヤーなのです。私たちがリードしたマイクロサービス革命で起きたことは、AIでも繰り返されます。

APIプラットフォームを構築するための最も戦略的な足がかりは、トラフィックレイヤーという「山脈の要所(マウンテン・パス)」を押さえることである、というのが私たちの長年の信念です。クラウドネイティブの世界ではAPIゲートウェイがそのブローカー技術でした。しかしエージェントの世界では、AIゲートウェイがAPIとモデル間のトラフィックを制御する次世代のコネクティビティブローカーとなります。AIトラフィックは従来の1,000倍以上の規模、すなわち「マシン・スケール」へと拡大します。

つまり、要所の地がシフトしているのです。最初はゆっくりと、そしてある時突然に。新しいAIトラフィックが急速に出現するにつれ、(クラウドにおけるRESTのように)新しいプロトコルが登場します。MCP(Model Context Protocol)はその最初の主流な形式ですが、AIが新しい方法で接続し会話することを可能にするプロトコルは今後さらに増えるでしょう。私たちの原則は、最も要求の厳しい企業の次なるニーズを常にサポートし続けます。

Kongは、まさにこの瞬間のために生まれました。APIを管理するために使用される「コネクティビティ・ロジック」、さらに言えば、セキュリティ、ガバナンス、加速、オブザーバビリティへのニーズは、AIトラフィックにおいてさらに重要になります。これらのトークンを効率的かつ安全に管理し届けることは、私たちが解決する新たな挑戦です。

APIは開発者のためのものです。MCPはLLMのためのものです。KongがAPIのコントロールプレーンとなったように、今後はAIトラフィックのコントロールプレーンとなります。プロキシされる価値の新しい単位はトークンです。各トークンは機密性の高いコンテキストを含んでおり、統治されなければなりません。トークンのスループットが効率を定義し、コスト管理が利益のプラスとマイナスの分かれ道となります。

ハイパーボリューム

「トークン工場」が増殖するにつれ、新たな「AIスケーリング則」が現れます。AIは、私たちがこれまで見たことのない桁違いの規模をもたらします。かつては10億回のAPIコールを達成することが企業の大きなマイルストーンでした。Kong Gatewayは現在、1日あたり数兆件のリクエストをエラーなく超高速で処理しています。これは莫大な数字ですが、エージェント型AI時代に訪れる規模には到底及びません。

AIのスケーリング競争とは、「ハイパーボリューム」において誰が勝つかという競争です。私たちは今、「京(Quadrillion)」、さらには「垓(Quintillion)」の単位に達するAPIリクエストとAIトラフィックに備えてインフラを準備しなければなりません。そのボリュームは単なるコールやトークンだけでなく、リアルタイムデータ、イベント、MCPのストリーミングセッション、LLMプロンプトなど多岐にわたります。それはマルチモーダルであり、複雑さは増大しています。単にトラフィック量が多いだけでなく、ヘテロジニアス(異種混合)なのです。今日までに構築されたハードウェアおよびソフトウェアインフラのほとんどは、ハイパーボリュームのためにゼロから再設計される必要があります。しかし、Kongは違います。Kongは当初からマルチモーダルなハイパーボリュームを想定して構築されているからです。

例えば2025年5月、GoogleのSundar Pichai CEOは、Geminiの月間トークン処理数が2024年5月から約50倍に爆発し、4,800億トークンに達したことを示すチャートを提示しました。そして10月までに、同社はすべてのGoogle AI製品全体で月間1.3「京(Quadrillion)」トークンに達したと発表しました。兆(Trillion)は到達困難な規模だと思われていましたが、AIが新しいスケーリング則を提示している今、私たちは京、そして間もなく垓の単位を確信しなければなりません。ハイパーボリュームです。

求められるのは「スピード」のみ

トークンは依然として非常に非効率です。無駄を省き、インテリジェンスを豊かに配布するためには、プロンプト圧縮、表記の最適化、セマンティックキャッシュ、インテリジェントルーティングが大規模に必要となります。これらはすべて、Kongが解決を支援するAIコネクティビティの課題です。

すでに驚異的なスピードで動いており、データセンターがトークン生成工場へと変貌しつつある世界において、収益は電力に結びつきます。そして、重要なのは次の2点だけです。「トークン数 × ワット数」と「トークン数 × 秒」です。前者は収益と利益率に直結するため重要です。後者は収益成長に関わるため不可欠です。ビジネスがより多くのトークンを処理できれば、それだけ多くの収益を生み出すことができます。京のスケールにおいて、0.5秒の遅延は実質的な収益の差を意味します。

「トークン = 収益」です。私たちは常に高速なアプリケーションと低レイテンシなバックエンド、および信頼性の高いAPIコールを求めてきました。今日、それは単に「フライト予約のために数秒待たされる」といったデジタル体験の速さだけの問題ではありません。これはAI競争における経済的生存の問題です。企業は自らを変革し、ハードウェアからソフトウェアに至るまで、最も速く最も効率的なAIスタックを手に入れなければなりません。例えばCPUの世界では、10%遅くても大きな問題にはなりませんでした。しかしGPUの世界では、パフォーマンスがすべてです。NVIDIAは10年前にこれを見抜き、誰よりも速い製品を作ることでGPU市場の大部分を掌握しました。

求められるのはスピードです。前述したように、今日私たちが目にしている「トークン数 × 秒」の数字は、依然として主に人間主導のものです。エージェントが主流になり、仕事を完遂するためにエージェント間で直接トークンを消費するようになれば、スループットの負荷はさらに増大します。しかし、ここには落とし穴があります。高速に動きトークンを迅速に移動させるためには、企業はセキュリティ、信頼性を確保し、問題が発生した際の「影響範囲」を限定できる新しいガードレールを構築しなければなりません。ここでも、私たちのチャンスはトラフィックレイヤーのコントロールタワーとして機能することにあります。トークンはインテリジェンスが移動する方法であり、スピードはそれが世界を動かす速さです。Kongはスピードそのものです。

新たなコネクティビティレイヤー

このかつてないスピードへの要求には、新たな「デジタルの鉄道」が必要です。ハイパーボリュームに対応し、光速で動き、ガバナンスを備えたコネクティビティレイヤー。エージェント、APIコール、モデル、トークンのための、すべてがガードレールに守られたレイヤー。それが「AIのためのコネクティビティレイヤー」です。私たちには、あらゆる企業が取り残されることなく繁栄し、スピードを上げ、安全にインテリジェンスを解き放つことを可能にするデジタル鉄道を構築するチャンスがあります。

新しいAIスタックが登場しつつあります。CoreWeaveのような新しいAIクラウド「ネオクラウド」、基盤モデル、LLMOps、推論プラットフォームなどがその一例です。この新しい波の「クライアント」は、もはやウェブサイトやサービス、アプリケーションだけではありません。AIエージェント、そして最終的にはロボティクス、つまり「マシン」です。これらすべてを繋ぎ止める接着剤となるコネクティビティレイヤーはどこにあり、なぜ今それが必要なのでしょうか?

私たちが賭けているのは、クラウドネイティブのマイクロサービスで現れたのと同じアーキテクチャパターンが、エージェンティックAIでも再来するという点です。約10年前、企業やテック企業のインフラにはより多くのトラフィックが押し寄せ、モノリスをマイクロサービスに分離して新しいスケーラブルなシステムを構築するために、コンテナ、Kubernetes、サーバーレス、YAMLファイル、CI/CDなどが誕生しました。バックエンドを自律的で小さなソフトウェアへと弾力的にスケールさせる動きが加速し、クラウドネイティブ時代が幕を開けました。

これらすべてを連携させるためにAPIが爆発的に普及し、新しいアプリやデバイスが生活に浸透するにつれて、HTTP RESTfulトラフィックが増大しました。当初、開発者はレート制限、ロギング、認証といった「ビジネス・コネクティビティ・ロジック」を、好みのプログラミング言語のライブラリを使ってマイクロサービスに直接組み込んでいました。しかし、マイクロサービスが数百規模に増えると、車輪の再発明を繰り返すことは研究開発コストの増大を招き、そこでAPIゲートウェイが誕生したのです。

コネクティビティ・ロジックは突如としてプロキシレイヤーへと移行しました。抽象化され、言語に依存せず、各サービスに適切なコントロール(レート制限など)を配信できるようになったのです。エンジニアリングはトラフィック管理ではなく、コアIPの構築に再び集中できるようになりました。API管理市場は急成長し、APIの構築、実行、発見、ガバナンスを支援するために、APIゲートウェイを中心とした完全なAPIライフサイクルが構築されました。

これがAIでも繰り返されています。当初、組織内には一握りのLLMしか存在せず、LangChainのようなフレームワークが登場しました。企業がAIネイティブな取り組みを成熟させるにつれ、より多くの大規模・中規模・小規模な言語モデルやエージェントがインフラに導入され、コール、イベントストリーム、トークンを通じてAIトラフィックを増大させます。以前と同様、新しいコネクティビティ・ロジックを構築する必要があります。AIトラフィックに対して、ガードレール、コスト管理、キャッシュなどを適用しなければなりません。エンジニアリングリソースは再び不足し、企業はこのAIコネクティビティ・ロジックをAIアプリやモデルから切り離し、中立的なプロキシレイヤーへと移行させようとするでしょう。

この中立的なレイヤーこそがAIゲートウェイです。そして、私たちがクラウドネイティブ革命をリードしたように、AIコネクティビティ時代も私たちがリードしています。Kongは、まさにこの瞬間のために生まれたのです。AIコネクティビティ時代の到来です。

Augusto Marietti

CEO & Co-Founder of Kong