AIゲートウェイとは

英語によるオリジナルはこちらでご覧いただけます。

Marco Palladino

CTO、共同創業者

AIとLLMの隆盛を背景に、企業が構築するアプリケーションや顧客体験に変革が起きています。これは、業界が転換点を迎える瞬間であり、テクノロジの進化が次の段階へと向かう転換点として、パラダイムシフトを伴う新たな時代が始まるのです。過去には、モバイルの台頭、クラウドの躍進、マイクロサービスの発展などの転換点がありました。AIをインターネットの誕生に匹敵する大変革だと言う人もいます。

KongのCTOとして、私自身APIの世界に深く関わっています。そのため、AIの利用をバックボーンとして支えているのはAPIだという点に、どうしても意識が向いてしまいます。

- 私たちはAPIを通じて、AIを利用しています。ブラウザ上のプロンプトを使っているとしても、その背後にはAPIがあります。

- AIは、APIを通じて世界とつながっています。そのことが本質的にAPIの急増をもたらします。AIからのアクセスを受け入れようとする製品やサービスは、ますます増えています

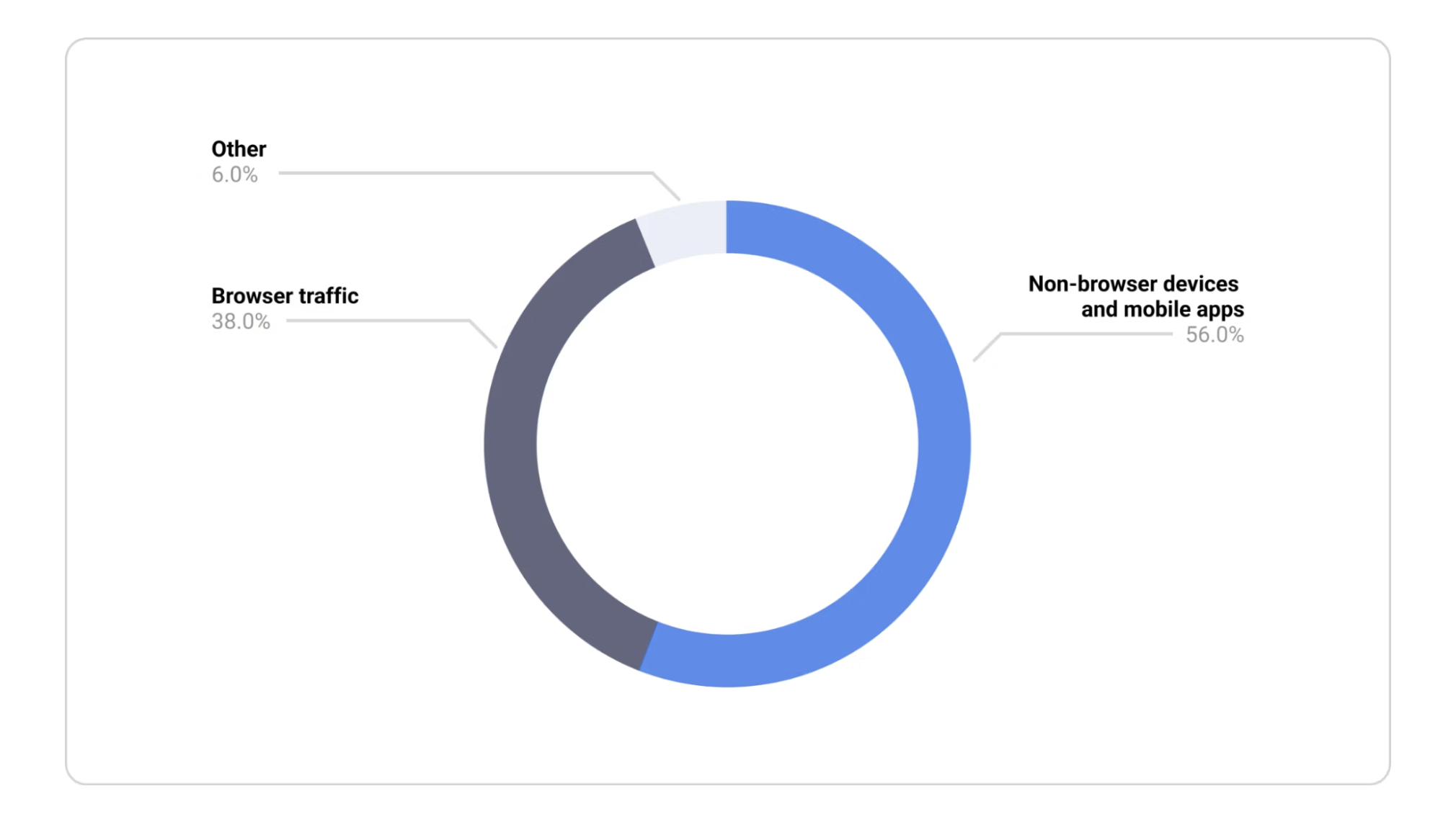

これまでも右肩上がりの勢いを見せていたAPIにとって、AIの普及はさらなる追い風となっています。現在のインターネットトラフィックのうち、APIトラフィックは83%以上を占めています。今やAIトラフィックという新たなカテゴリも生まれています。近い将来、APIトラフィックは果たしてどのくらい増え、そのうちのどの程度がAI関連のトラフィックになるのでしょうか。現在のAPIトラフィックは、モバイルデバイスやウェアラブルデバイスなど、ブラウザ以外によるトラフィックが大部分を占めています。今後、APIトラフィックの大部分を、AIが席巻することが予想されます。

これは、APIトラフィックの種類を示したグラフです。近い将来、APIトラフィック全体のうち、どの程度をAIが占めることになるのでしょうか。

AIの導入

プロダクトにAIを取り入れるために、すべての開発者や組織にまず求められるのが、ベストプラクティスを新規で策定することです。そして、AIの利用に対する統制とセキュリティ対策を根底から確立するための、新たなテクノロジを導入する必要があります。

具体的には、次のような多局面にわたる取り組みが必要となります。

- AIとデータのセキュリティ:顧客情報や機密データが、AIやLLMに送り込まれるのを防がなくてはなりません。個人情報の流出、セキュリティのエスカレーション、データ侵害につながる事態を回避することは必須事項です。

- AIのガバナンス:アプリケーションやチームが利用するすべてのAIプロバイダやAIモデルに関して、社内で生成されるAIトラフィックの管理、保護、観測を単一のコントロールプレーンで行えるようにして、AIの使われ方を制御する必要があります。こうした可視化と制御が可能なAIコントロールプレーンを取り入れていない企業は、社内のチームのプロダクトでAIがどのように導入されているかが把握できず、その使用方法が適切かどうかも判断できません。

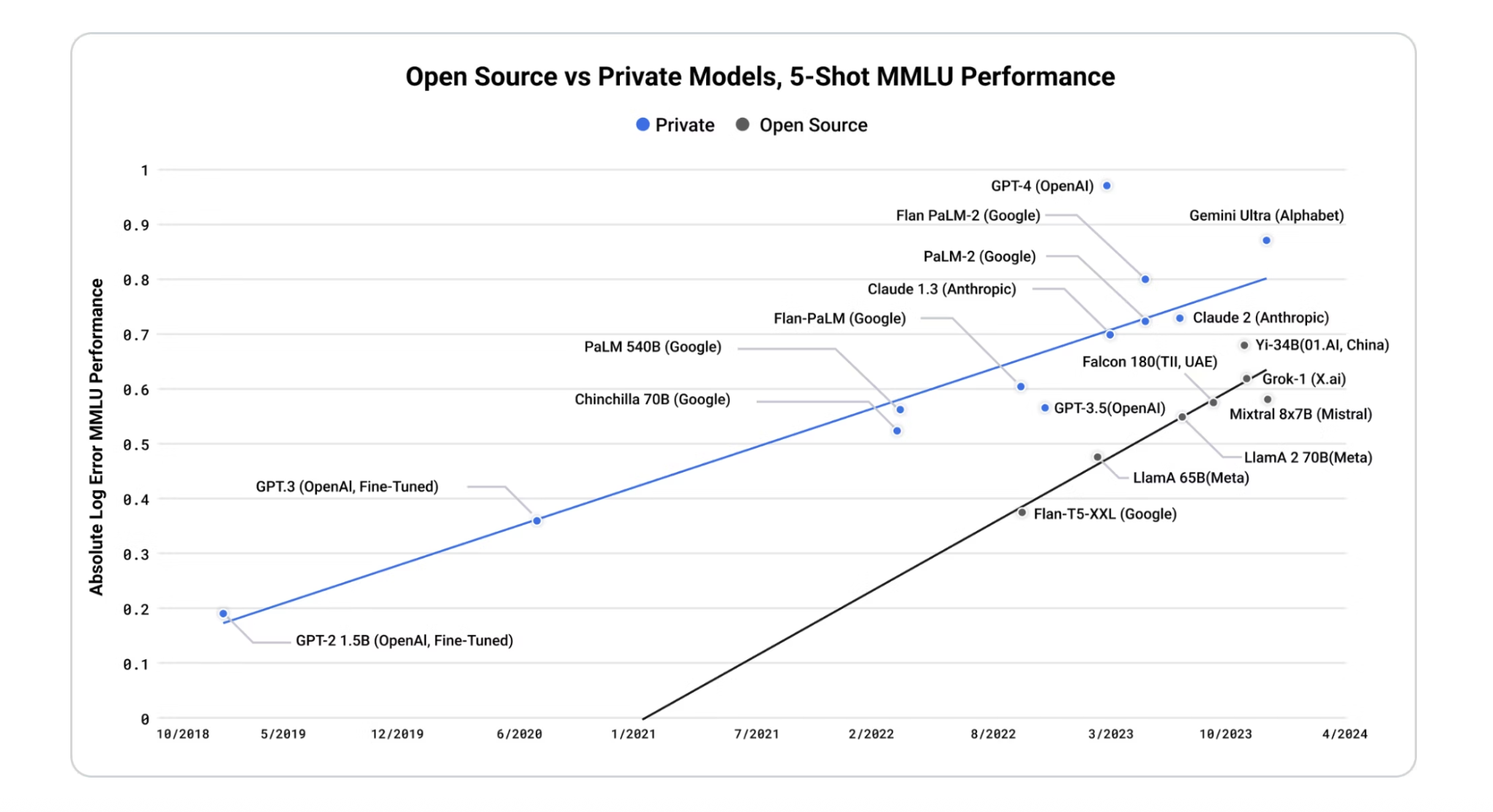

- マルチAIの採用:ジョブごとに最適なAIを活用可能な体制を築く必要があります。また、複数のLLMやモデルの統合に必要な時間を短縮する必要があります。汎用LLMと特化型LLMは、今後さまざまなタスクに合わせて導入されていきます。開発者は、自社の要件に適合したクラウドホスティングモデルやオープンソースモデルの採用を進めることでしょう。OSSのモデルは、パフォーマンスや知能の面で急速に進化しています。

オープンソースのモデルの進化は急速に進み、一部のプライベートなモデルを凌駕する勢いです。出典:ARK Invest

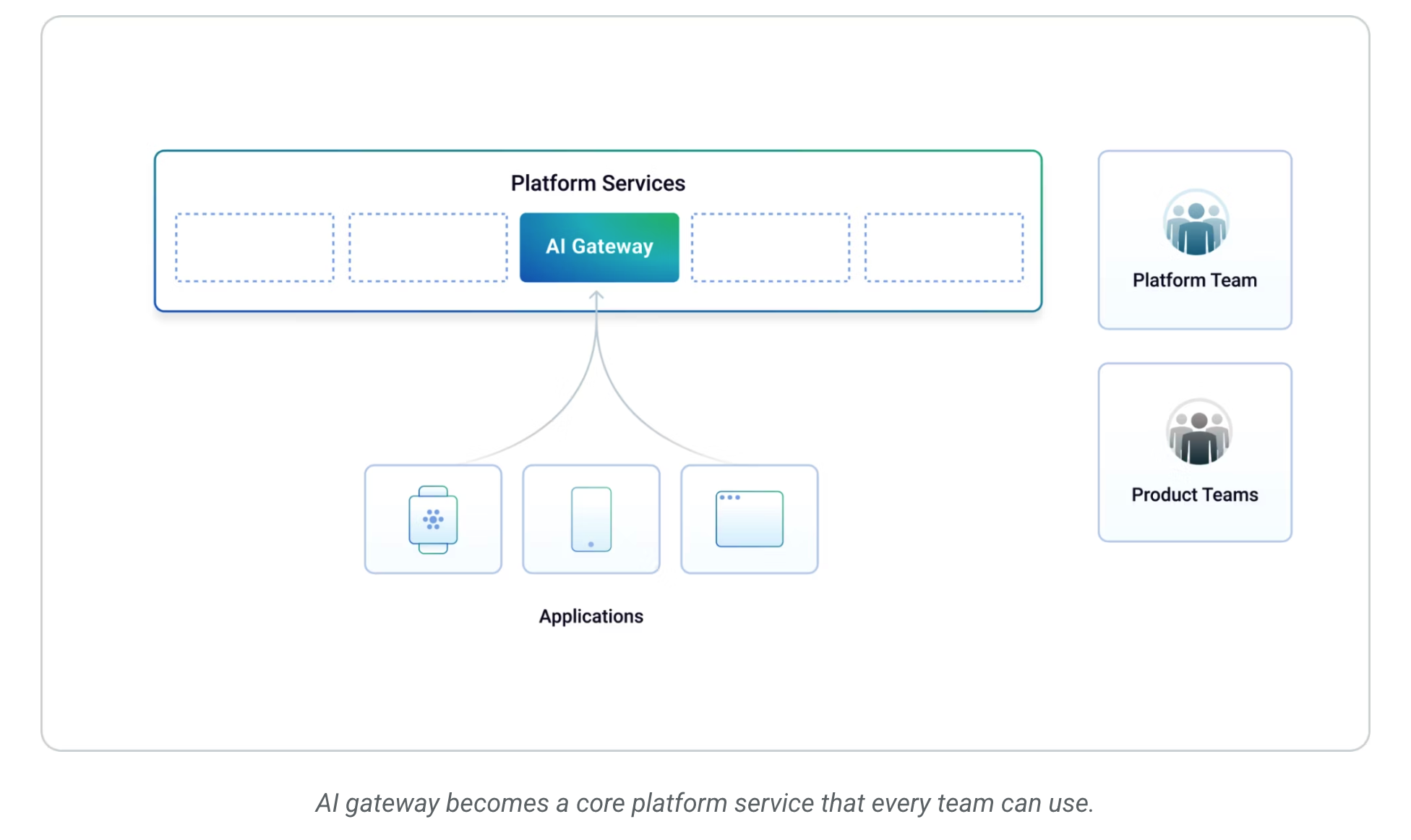

社内でのAI導入が進むなかで、開発者が本来取り組むべきは、迅速なイテレーションや新機能の開発です。AIの利用に伴う横断的関心事への対応ではありません。そのため、アプリケーションチームの生産性を向上し、社内でのセキュアで責任あるAI利用を進めるためには、企業は自社のコアプラットフォームのサービスの1つとしてAIを提供する必要があります。そして、社内のあらゆるプロダクトが必要に応じて利用できるようにしなくてはなりません。それにより、社内の複数のチームがAIを導入する際、いわゆる「車輪の再発明」を防ぐことができます。

AI Gateway とは、Buzzword以上のもの?

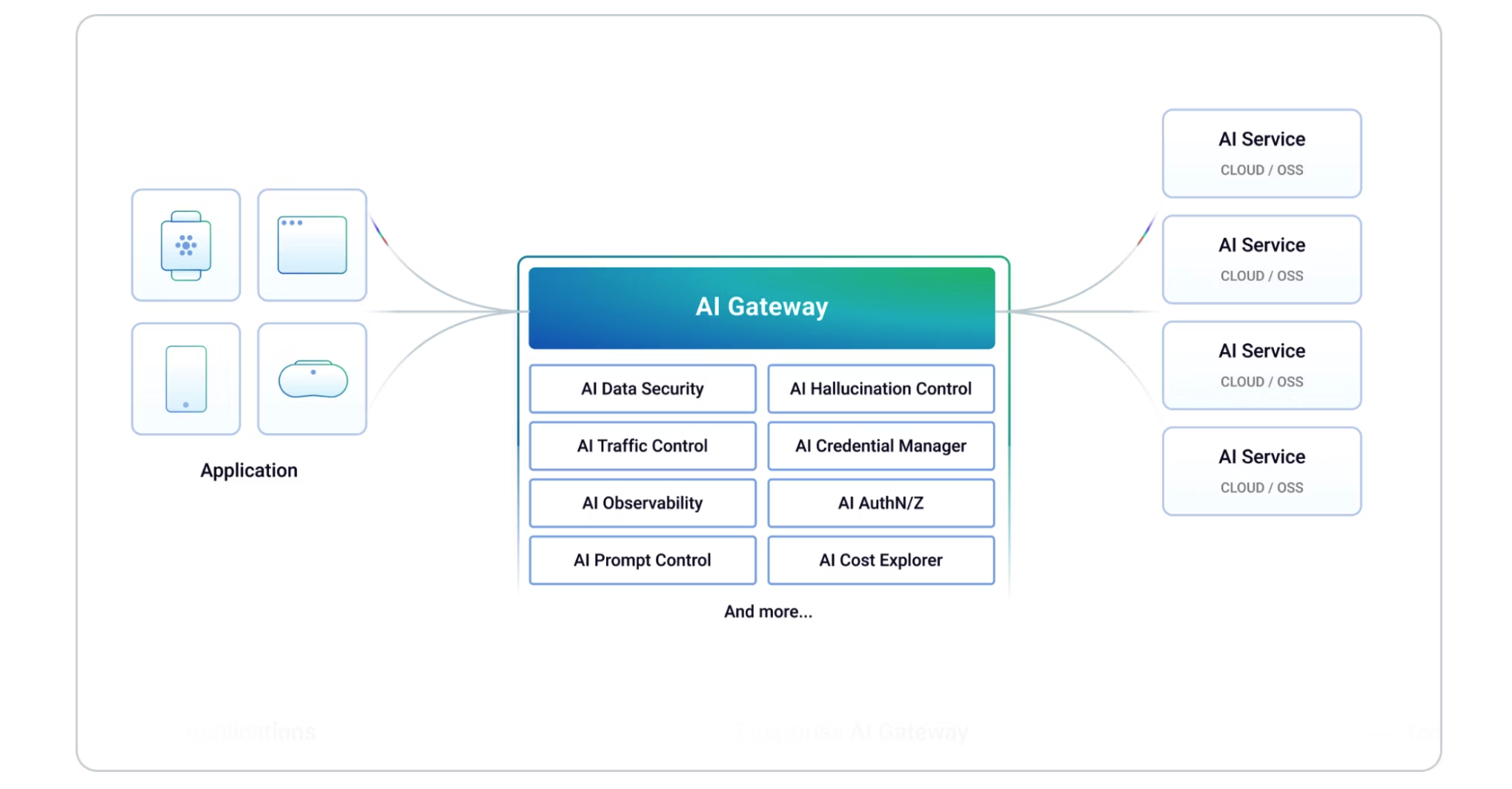

AI Gateway は、大規模言語モデルやその他の AI 搭載サービスとのやり取りを管理および保護するために特別に設計された、専用のミドルウェア層です。アプリケーションと AI モデルの間に位置し、リクエストのルーティング、認証、認可、レート制限、トラフィックの監視などの重要な機能を処理します。

社内のAI導入を促進し、適切なレベルのオブザーバビリティ、セキュリティ、ガバナンスを確保するために、企業は今後、AIゲートウェイの導入に乗り出すことになります。AIゲートウェイは、開発者が利用するあらゆるLLMやモデルへのアクセスを可能にする、分散型のAIイグレス(出口)を提供します。AIモデルがクラウドホスティングとセルフホスティングのどちらであるかを問わず、社内のすべてのチームのAIアクセスを一元管理できます。

AIゲートウェイは、従来のAPIゲートウェイと同じように動作します。つまり、内部APIを他のクライアントに公開するためのリバースプロキシとしてではなく、社内のアプリケーションが生成するAIトラフィックを処理するためのイグレスプロキシとしてデプロイします。AIゲートウェイは、クラウドかセルフホスティングかなど、バックエンドのAIモデルのホスティング場所に応じて、トラフィックを社外または社内に送信します。

AIを導入する際には、対処が必要な横断的関心事が数多くあります。ここに示したのは一部です。

社内でのAI導入が広がるなか、共通する横断的関心事に各アプリケーションが個別に対処せずに済むようにして、チームのイノベーションを推進する必要があります。AIゲートウェイを導入することで、複雑化、断片化、セキュリティの盲点、シャドーITが発生するリスクを抑え、全般的な非効率化やコスト上昇を避けるべきです。

APIの利用に伴い生じる横断的関心事への対応と同様に、AIの利用に伴う横断的関心事はAIゲートウェイで対処します。アーキテクチャのシンプル化を実現するために、プラットフォームチームがAIゲートウェイを管理し、社内のコアサービスとしてAIへのアクセスを必要とする各アプリケーションに提供するのが理想的です。こうした構成のメリットは、社内のすべてのAIトラフィックを管理するための統合コントロールプレーンが確立され、セキュリティポリシーの実装やオブザーバビリティデータの収集をより迅速に行えるようになることです。また、AIにアクセスする必要が生じたアプリケーションの担当チームのオンボーディングを、開発者向けパイプラインで自動化できる可能性もあります。

AIゲートウェイは、各チームが利用できるコアプラットフォームサービスになります。

AIゲートウェイのバックエンドでは、複数の種類のAI(OpenAI、Mistral、LlaMA、Anthropicなど)を利用できます。一方で、AIゲートウェイがアプリケーションに提供するAPIインターフェースは、1種類です。開発者はその共通インターフェースを通じて、ニーズに合ったAIモデルにアクセスできます。バックエンドで稼働するあらゆるAIのセキュリティ認証情報は、AIゲートウェイで一元管理できます。サードパーティのAIで認証情報のローテーションや取り消しを行ったときに、アプリケーションを更新する必要はありません。

プロンプトのセキュリティ、検証、テンプレート生成は、このAPIゲートウェイで実装できます。プロンプト本体を1つのコントロールプレーンで管理できるようになり、クライアントアプリケーションの更新なしで変更を加えられます。AIに出す指示は、プロンプトが核となります。コンプライアンスに沿った責任あるAI利用を徹底するためには、アプリケーションにどのようなプロンプトの生成を認めるかを管理統制する機能がきわめて重要です。規制対象のトピック(例えば政治的なトピック)に関するAI統合を開発者が構築したり、プロンプトで誤って設定した不適切なコンテキストを悪意のあるユーザーに後から不正利用されたりするような事態は避けなくてはなりません。

企業では、さまざまなチームによりさまざまなAIサービスが利用されることになります。そこでAIゲートウェイは、共通のインターフェースを通じて複数のモデルにアクセスする機能を提供できます。それにより、複数のモデルでのAIの実装がシンプルになり、モデル間の切り替えも簡単です。

AIゲートウェイでは、認証または認可、レート制限、APIライフサイクル全体のガバナンスなど、追加のセキュリティ機能を実装することも可能で、社内のチームのAIアクセスに対する管理を強化できます。基本的に、AIトラフィックはAPIトラフィックです。

AIのオブザーバビリティは1カ所で管理できます。サードパーティのログまたはメトリクス収集ツールにデータを送信することも可能です。一元的な設定のもとで、社内で生成されたすべてのAIトラフィックを簡単にキャプチャし、データのコンプライアンスや変則的な使用方法に対するチェックを強化できます。

最後に、コストも重要な要素です。ご存じのとおり、AIモデルの稼働には、多額のコストがかかります。AIゲートウェイを利用して、社内でのAIの使用状況を把握し、コスト削減策の導入や最適化に反映できます。

まとめ

人工知能は、近年の生成AIとLLM技術の発展を追い風にした、10年に1度のテクノロジ革命です。このテクノロジ革命は業界を掻き乱し、企業各社が顧客向けに構築するアプリケーション体験を一変させることでしょう。

モバイル革命やマイクロサービスなどのように、APIはこれまでも、新たなユースケースの登場が原動力となってきました。AIが加わったことで、世界のAPIトラフィックはさらに増えます。ここで言うAPIには、私たちのアプリケーションがAIモデルと通信するために利用するAPIと、AIモデルが世界とつながるために利用するAPIとがあります。

AIの利用には課題が伴います。AIモデルは、場合によっては複数のアプリケーションでの共有が可能です。さらには、複数の企業間で共有されることすらあります(共有環境でホスティングされているフルマネージドのクラウドモデルなど)。こうしたモデルを利用した場合、データコンプライアンスの面で重大な問題が生じます。また、企業が送受信するAIトラフィックに関して、他の種類のAPIトラフィックと同様の保護、統制、観測が必要です。こうしたことから、本番環境でAIを利用するためには、かなりのインフラを導入する必要があります。

AIゲートウェイが導入されていれば、開発者は既製のソリューションをそのまま利用して、AIをセルフサービスですばやく活用できます。AIインフラの構築や、AIインフラに求められる横断的機能の実装を、開発者が自ら行う必要はありません。AIゲートウェイを通じて、社内のすべてのチーム、すべてのアプリケーションにより生成されるAIトラフィックを完全に制御できるのは、企業にとって安心です。適切な抽象化を取り入れて、コンプライアンスに沿った責任あるAI利用を確実に推進できます。