Kong AI Gateway 3.11 – マルチモーダル対応とトークン利用量の削減

英語によるオリジナルはこちらでご覧いただけます。

マルチモーダル機能、AI Prompt Compression、AWS Bedrock Guardrailsとの統合

本日、当社が提供するKong AI Gatewayの最大級のリリース(3.11)を発表いたします。このリリースには、現代的で信頼性の高いAIエージェントを本番環境で構築するために不可欠な複数の新機能が搭載されています。AIインフラストラクチャの最新機能をご利用いただくため、このバージョンへのアップデートを強くおすすめいたします。変更履歴の全文は、こちらからご確認いただけます。

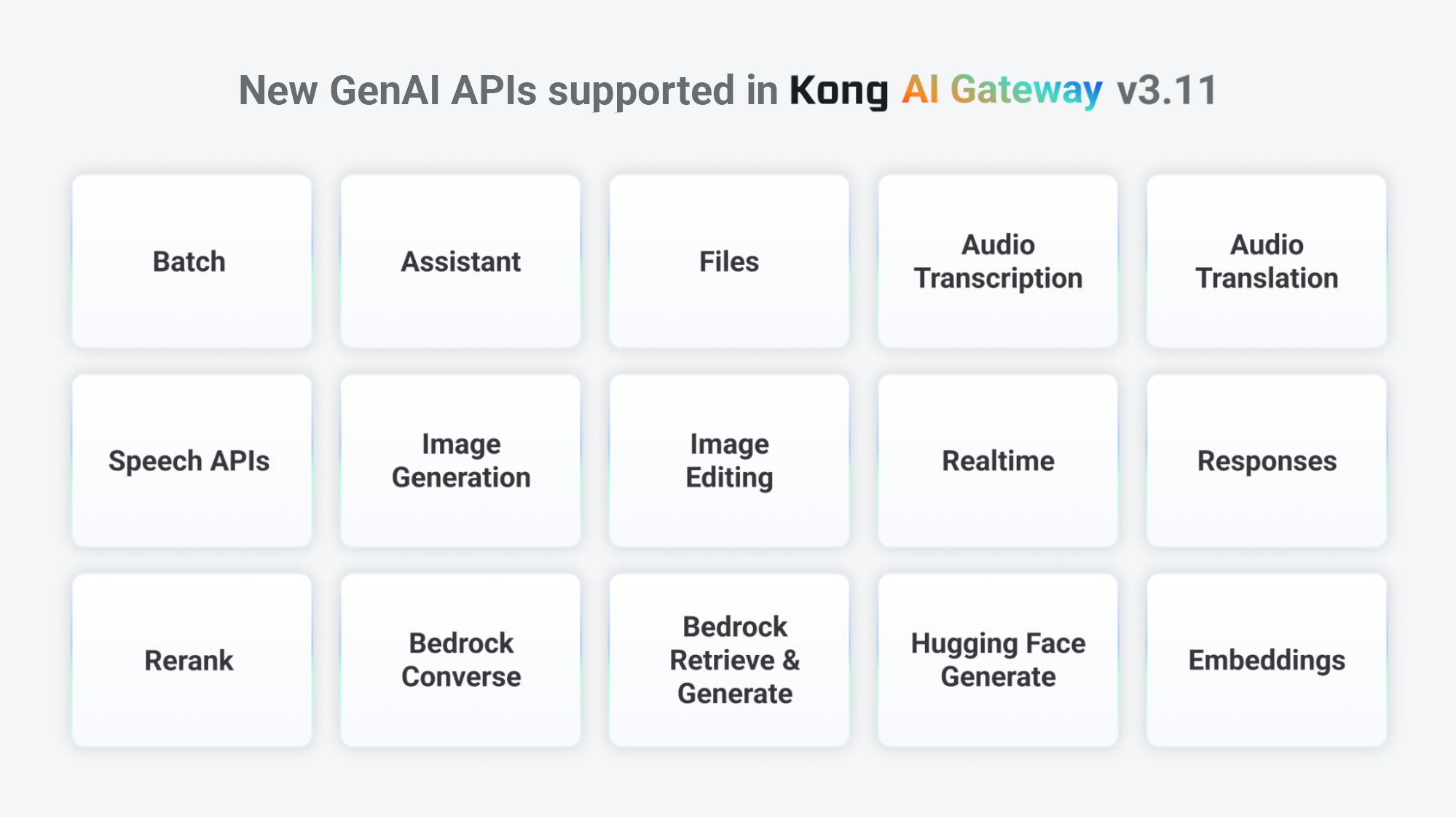

マルチモーダル エンドポイントを含めた生成AI機能強化

このKong AI Gatewayの新しいリリースは、当社が標準機能として提供する新たな生成AI(GenAI)機能の広範な範囲において、非常に重要な意味を持ちます。

Azure | OpenAI – Batch, Assistants, and Files:

- Batch – 複数のLLM呼び出しの効率的な並列実行を可能にし、スケールアウト時の遅延とコストを削減します。

- Assistants – マルチステップAIワークフローのオーケストレーションを簡素化し、開発者が状態保持型でツール拡張可能なエージェントを構築できるようにします。

- Files – ドキュメントとコンテキストの永続的なストレージを提供し、セッションを越えたLLMとのより豊かで情報に基づいたインタラクションを可能にします。

Azure | OpenAI – Audio Transcription, Translation, and Speech API:

- Audio Transcription – 音声入力をテキストに変換し、通話要約、音声エージェント、会議分析などに活用します。

- Real-Time Translation – 音声入力を言語間で変換し、多言語対応の音声インターフェースを実現します。

- Text-to-Speech – LLMの応答から自然な音声を生成し、音声ベースのエージェントを強化します。

Azure | OpenAI | Gemini | AWS Bedrock – Image Generation and Edits API:

- Image Generation – テキストプロンプトからクリエイティブ、マーケティング、デザイン用途向けの画像を生成します。

- Image Editing – 指示とマスクを使用して既存の画像を編集し、動的なコンテンツワークフローに役立ちます。

- Multimodal agents – エージェントに視覚的な入力/出力機能を搭載し、ユーザー体験(UX)とタスク範囲を拡張します。

Azure | OpenAI – Realtime API:

- Stream Completions -トークン単位のストリーム出力を高速かつインタラクティブなユーザー体験を実現します。

- Low latency – チャットUIにおける最初のトークンまでの時間を短縮し、応答性を向上させます。

- Analytics – ストリームの動作とパフォーマンス指標を監視します。

Azure | OpenAI – Responses API:

- Response metadata – 各LLM出力のアクセスログ、関数呼び出し、ツールの使用状況にアクセスできます。

- Debugging and evaluation – 高度な可観測性とレスポンスレベルの品質チェックを有効化できます。

- Control and tuning – メタデータを使用して、再ランキング、再試行、またはハイブリッド生成戦略を構築できます。

AWS Bedrock | Cohere – Rerank API:

- Context Reranking – RAGパイプラインで取得した文書と結果の関連性を向上させます。

- Flexible inputs – プロンプトの文脈に基づいて再順序付けする候補のリストを任意の形式で送信できます。

- Improved accuracy – より適切な文脈への照合により、最終的なLLM応答の品質を向上させます。

AWS Bedrock – AWS Bedrock Agent APIs:

- Converse / ConverseStream – ストリーミングの有無に関わらず、ステップバイステップのエージェント計画を実行し、高度なオーケストレーションを実現します。

- RetrieveAndGenerate – 1つのAPI呼び出しで取得と生成を組み合わせ、RAGを簡素化します。

- RetrieveAndGenerateStream – RAGの結果をストリーミングし、リアルタイムのエージェント体験を提供します。

Hugging Face – Generate and Generate_Stream API:

- Generate – さまざまなタスクと業界でテキスト生成にオープンソースモデルを活用します。

- Generate Stream – チャットやライブ推論のユースケース向けに、テキスト出力をリアルタイムでストリーム配信します。

- Open model ecosystem – Hugging Faceの豊富なモデルライブラリを活用し、柔軟性を最大限に活用できます。

Azure | OpenAI | Gemini | AWS Bedrock | Mistral | Cohere – Embeddings API:

- Text-to-embedding conversion – テキストをセマンティック検索、クラスタリング、レコメンド、RAGなどに活用するためのベクトル表現に変換します。

- Multi-vendor support – OpenAI、Azure、Cohere、Mistral、Gemini、Bedrockの埋め込みモデルを統一されたインターフェースで利用可能。OpenAI互換モデルを含むすべてのモデルに対応しています。

- Analytics – トークン使用状況、類似度スコア、遅延メトリクスを追跡し、可観測性を確保します。

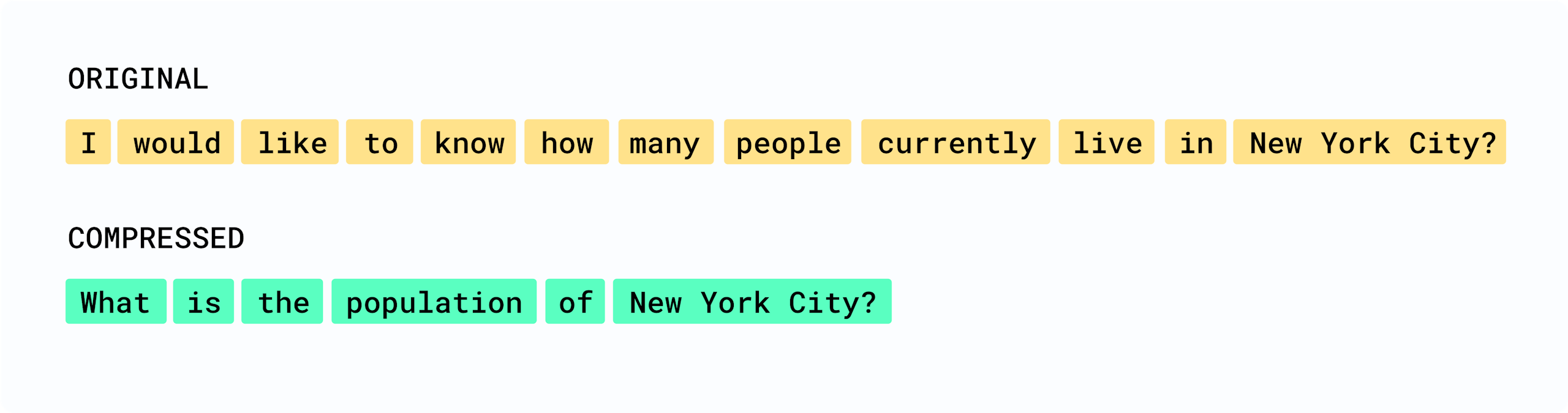

新たなPrompt Compressionプラグイン

生成AIアプリケーションの普及が進むにつれ、LLMへのリクエスト件数が増加し、コストも比例して上昇しています。ビジネスにおけるコストと同様、効率化によるコスト削減を検討する必要があります。LLMのコストは通常、トークン使用量に基づいて算出されます。つまり、プロンプトが長くなるほど、1リクエストあたりのトークン消費量が増加します。プロンプトには、意味の意図を損なわずに削除または短縮可能なパディングや冗長な単語・フレーズが含まれることが多く、これらを最適化することでコスト削減が可能です。

実質的にトークン数を半分に削減しました。圧縮率やターゲットトークン数は調整可能です。当社のテストでは、このアプローチによりコストを最大5倍削減しつつ元のプロンプトの意図した意味の80%を維持できることが確認されています。

詳細な例は、ドキュメントをご覧ください。

実際の使用では、プロンプトははるかに大きく、自動コンテキスト注入(システムプロンプトやRetrieval Augmented Generation (RAG) コンテキストの注入など)によりさらに拡大されます。この追加のコンテキストも圧縮可能です。実際、当社のテストでは、元のプロンプトの忠実度を維持しつつコンテキストを圧縮することで、コスト削減と意図の保持の最適なバランスを実現できることが確認されています。

これは、Kongで既に利用可能な他のコスト削減措置と補完関係にあります。例えば、Semantic Cachingは、類似の要求が既に回答されている場合にLLMサービスへのアクセスを回避し、AI Rate Limitingはアプリケーション、チーム、またはユーザーごとに時間ベースのトークンまたはコスト制限を設定できます。

新たなAWS Bedrock Guardrailsサポート

生成AIアプリケーションが予測不能な出力を生成することがあることはよく知られています – アプリケーションへの信頼は、わずかなミスによって急速に失われる可能性があります。AI駆動型アプリケーションを「適切な範囲内に保持する」、不適切な言葉や表現をブロックする、個人を特定可能な情報を削除する、そして幻覚を軽減する能力が必要です。ガードレールが必要です。

現在、Kong AI Gatewayを使用すれば、組み込みのPII SanitizerとSemantic Prompt Guardプラグインを利用して、PIIデータを非表示にするポリシーを既に実装できます。また、Azure AI Content Safetyを活用し、Azureの管理型ガードレールサービスに接続するポリシーもサポートしています。

本日、私たちは AWS Bedrock Guardrailsのサポートを発表し、AIアプリケーションを悪意のあるものや意図しない結果から保護するお手伝いをします。詳細な例は、ドキュメントでご確認いただけます。

Kong AI Gatewayの製品オーナーとして、アプリケーションの監視を継続し、品質の段階的な改善を提供し、アプリケーションのコードを変更することなくポリシーを調整して即座に対応できます。Kong AI Gatewayは、AI駆動型アプリケーションとイノベーションの展開におけるリスクを管理し、信頼性を高めるお手伝いをします。

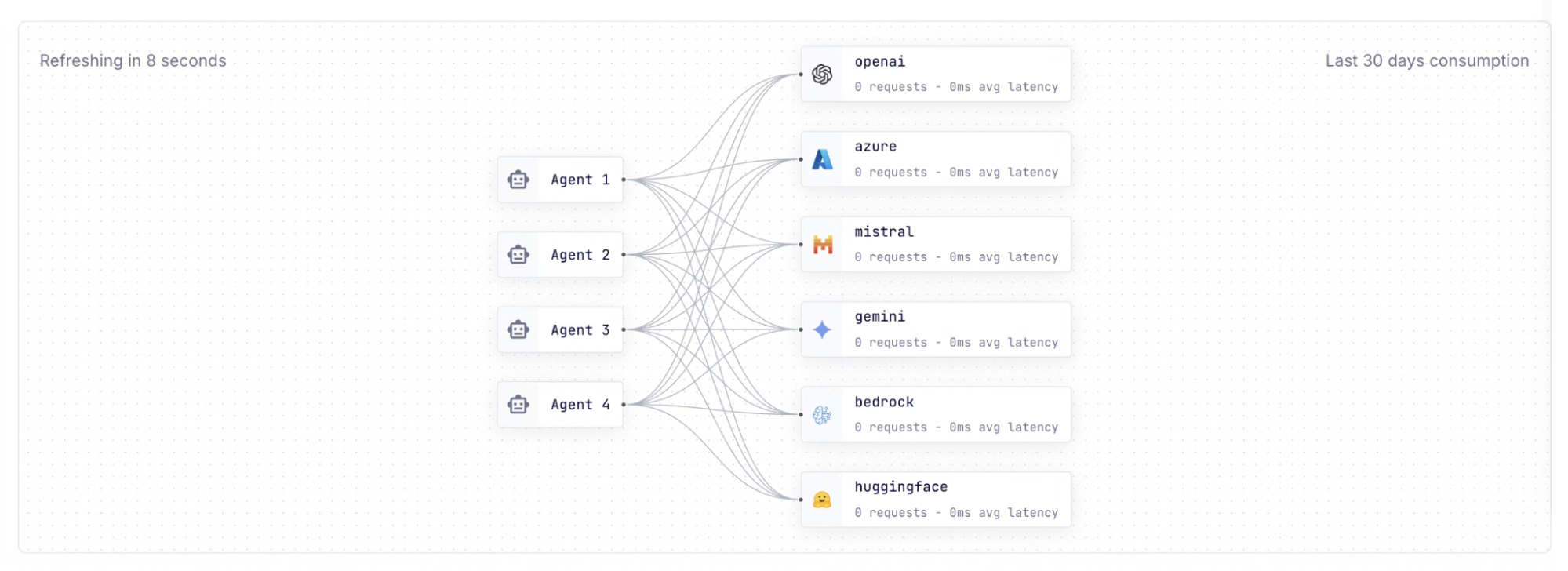

AI ManagerによるAIトラフィックのビジュアル化

最近、Konnectに新しいAIマネージャーを導入しました。これにより、AIエージェントがLLMを簡単に利用できるようにし、さらに新しいユーザーインターフェースからブラウザ上で直接、LLMのトラフィックを管理、保護、監視することが可能です。

AIマネージャーでは以下の機能が利用可能です:

- Konnect経由でAIポリシーを管理: セルフマネージドまたはフルマネージドのAIインフラストラクチャにおいて、AIトラフィックを管理、保護、加速、監視できます。

- LLMカタログのキュレーション: AIエージェントやアプリケーションが利用可能なLLMを確認し、カスタムアクセス権限とガバナンス制御を設定できます。

- エージェントマップの可視化: 組織に公開したLLMを消費しているエージェントを、いつでも確認できます。

- LLMアナリティクスの監視: カスタムダッシュボードとインサイトを活用し、トークン、コスト、リクエストの消費量を測定し、AIトラフィックの詳細な分析が可能です。

新しいAIマネージャーについて詳しくはこちらをご覧ください。

AI Gatewayによる新たなAI活用をお試しください

Kong AI Gatewayの新しいリリースを試してみませんか?Konnect Plusで無料で開始できます。すでにKonnectアカウントをお持ちの場合は、公式製品ページまたはデモとチュートリアルに直接アクセスしてください。

AIの実験段階から生産環境対応のAIシステムへの移行について詳しく知りたい方は、最新のAIインフラストラクチャを活用して実際のAI価値を創出する方法に関するウェビナーをご覧ください。